راهنمای جامع هوش مصنوعی ابری بومی: آینده پردازش توزیعشده

مقدمه: انقلاب هوش مصنوعی ابری بومی

هوش مصنوعی ابری بومی (هوش مصنوعی ابری بومی) بهعنوان پارادایمی که توسعه، استقرار و بهرهبرداری از مدلهای هوشمند را بومیسازی میکند، در حال بازتعریف اصول طراحی سیستمهای AI است. در نگاه فنی، این رویکرد تلفیق الگوهای کانتینری، اورکستراسیون مبتنی بر Kubernetes، و معماریهای میکروسرویس را با نیازهای محاسبات شتابیافته (از جمله GPU، TPU و شتابدهندههای تخصصی) برای اجرای بارهای آموزش و استنتاج ترکیب میکند. نتیجه به دست آوردن یک پشته نرمافزاری است که از نظر مقیاسپذیری، قابلیت بازیابی و بهینهسازی تأخیر برای پردازش توزیعشده هوش مصنوعی (پردازش توزیعشده هوش مصنوعی) مناسب است.

در این مدل، زیرساخت ابری منطقهای (زیرساخت ابری منطقهای) نقش کلیدی دارد: انتخاب مراکز داده نزدیک به کاربر نهایی باعث کاهش latency، افزایش حریم خصوصی داده و رعایت مقررات دادههای محلی میشود. از منظر عملکرد، تکنیکهایی مانند تقسیم داده (data parallelism)، تقسیم مدل (model parallelism)، و لایهبندی خطوط لوله (pipeline parallelism) به همراه بهینهسازیهایی همچون mixed precision و quantization، هستهی بهینهسازی عملکرد هوش مصنوعی (بهینهسازی عملکرد هوش مصنوعی) را تشکیل میدهند.

یک مثال برای روشنتر شدن: تصور کنید یک شبکه حملونقل هوشمند که بهجای ارسال همه بستهها به یک مرکز پستی مرکزی، بستهها را در مراکز محلی توزیع و پردازش میکند تا مسیرها کوتاهتر و زمان تحویل کمتر شود؛ همین ایده برای پردازش توزیعشده مدلهای بزرگ AI نیز صادق است. در ادامه با تحلیل تاریخی، مثالهای واقعی و راهکارهای فنی عمیقتر به این موضوع میپردازیم.

پیشینه تاریخی: تکامل زیرساختهای ابری

تاریخچه انتقال از مراکز داده متمرکز به معماریهای توزیعشده نشان میدهد که تحولات کلیدی در سه لایه رخ داده است: لایه سختافزار (شتابدهندهها و شبکههای با پهنای باند بالا)، لایه مجازیسازی و کانتینری (کانتینرها، CRIها و Kubernetes)، و لایه سرویسها (میکروسرویسها و APIهای مدیریت مدل). در دهه اخیر، ظهور کانتینرها و اورکستراسیون، همراه با رشد دسترسی به GPUهای کلاس دیتاسنتر، امکان شکلگیری استراتژیهای cloud-native برای AI را فراهم کرد.

از منظر معماری، حرکت از یک مدل monolithic به معماریهای توزیعشده به سازمانها امکان میدهد:

– بارهای آموزش را بر نُدهای متعدد با همافزایی شبکهای توزیع کنند؛

– خدمات استنتاج را نزدیک به محل تولید و مصرف دادهها مستقر کنند؛

– از زیرساخت ابری منطقهای برای رعایت الزامات قانونی و کاهش هزینههای انتقال بهرهمند شوند.

تکنیکهای قدیمی مانند parameter server جای خود را به روشهای جدیدتر مانند all-reduce مبتنی بر شبکههای با پهنای باند بالا و RDMA دادهاند. بهعلاوه، ظهور استانداردهای جدید در مدیریت چرخه حیات مدل (MLOps) و ابزارهای نظارت و مانیتورینگ باعث شد که بهینهسازی عملکرد هوش مصنوعی و تضمین کیفیت سرویسها در محیطهای cloud-native عملیاتیتر شود.

از نظر هزینه و دسترسپذیری، SMEها اکنون میتوانند با استفاده از راهکارهای اشتراکی و زیرساخت ابری منطقهای، بهینهسازی هزینه انجام دهند. رشد تکنولوژی باعث شده تا پیادهسازی راهکارهای توزیعشده برای سازمانهای کوچک و متوسط (راهکارهای ابری برای کسبوکارهای کوچک و متوسط) نیز مقرونبهصرفه شود.

روند فعلی: پروژه Latam-GPT به عنوان نمونه موفق

یکی از نمونههای برجسته عملیاتیسازی هوش مصنوعی ابری بومی، پروژه Latam-GPT است که بهصورت متنباز و مشارکتی در آمریکای لاتین توسعه یافته است. این پروژه، با گردآوری حدود ۸ ترابایت داده و آموزش یک مدل با ۵۰ میلیارد پارامتر، نشاندهنده توان عملیاتی زیرساخت ابری منطقهای و استراتژیهای پردازش توزیعشده است. زیرساختی که برای این پروژه فراهم شده است شامل سرمایهگذاری تقریباً ۱۰ میلیون دلاری در ابرشَما (supercomputing) دانشگاه تاراپاکا با ۱۲ نود و هر نود مجهز به چندین GPU از نوع Nvidia H200 است [منبع: Wired].

از لحاظ فنی، Latam-GPT نشان میدهد که چگونه:

– ترکیب دادههای محلی از ۲۰ کشور و ساختاردهی زبانی مختص منطقه میتواند کیفیت و قابلیت تطبیق مدل را افزایش دهد؛

– بهکارگیری نُدهای محاسباتی منطقهای، هزینه انتقال داده و تأخیر را کاهش میدهد؛

– طراحی کانالهای همکاری و شراکتهای استراتژیک (۳۳ شراکت) امکان دسترسی به مجموعههای داده بزرگ را برای پروژههای متنباز فراهم میکند.

برای مهندسی مدل در چنین محیطی، مهندسان از تکنیکهایی مانند تقسیم دیتا و مدل همزمان، mixed precision برای کاهش مصرف حافظه، و pipeline parallelism برای افزایش بهرهوری GPU استفاده میکنند. این رویکرد همچنین بر ضرورت طراحی شبکههای داخلی با پهنای باند بالا و بهرهگیری از پروتکلهایی مانند RDMA برای کاهش هزینه ارتباطات بین نُدها تأکید دارد.

برای اطلاعات بیشتر درباره مشخصات و اهداف این پروژه میتوانید به گزارش تفصیلی در Wired مراجعه کنید: https://www.wired.com/story/latam-gpt-the-free-open-source-and-collaborative-ai-of-latin-america/ و همچنین اسناد منتشرشده توسط مرکز ملی هوش مصنوعی شیلی (CENIA) را بررسی کنید.

بینش تخصصی: مزایای هوش مصنوعی ابری بومی برای SMEها

برای کسبوکارهای کوچک و متوسط (SMEها)، اتخاذ استراتژی هوش مصنوعی ابری بومی میتواند مزایای ملموسی داشته باشد. تحلیل فنی این مزایا به شرح زیر است:

– کاهش هزینههای زیرساختی تا ۴۰٪: با استفاده از اشتراک منابع در زیرساخت ابری منطقهای، نمونهسازی مدلها و استفاده از تسهیلات شتابدهنده بهطور مشترک، SMEها میتوانند هزینههای سرمایهای را بهطور چشمگیری کاهش دهند. از منظر فنی، استفاده از کانتینرسازی و اتوماسیون مقیاسپذیری باعث صرفهجویی در منابع محاسباتی میشود.

– بهبود عملکرد پردازش تا ۳۵٪: با استقرار نُدهای استنتاج نزدیک به منابع داده و استفاده از تکنیکهای بهینهسازی عملکرد هوش مصنوعی مانند quantization، pruning و mixed precision، زمان پاسخدهی و نرخ پردازش افزایش یافته و هزینههای عملیاتی کاهش مییابد.

– مقیاسپذیری خودکار بر اساس نیاز: الگوهای autoscaling بر مبنای معیارهای سطح مدل (latency، throughput، queue depth) و با هماهنگی orchestration میتواند منابع را بهصورت پویا توزیع کند. پیادهسازی horizontal scaling برای استنتاج و vertical scaling هنگام آموزش مدلهای کوچکتر، ترکیب مطلوب را ارائه میدهد.

– امنیت پیشرفته دادههای حساس: استفاده از زیرساخت ابری منطقهای به همراه رمزنگاری در حال استراحت و در حین انتقال، کنترل دسترسی مبتنیبر نقش و تفکیک مشتری (multi-tenancy isolation) و فنون SME-aware برای مدیریت دادهها، تضمین انطباق با قوانین محلی را تسهیل میکند.

علاوه بر این مزایا، SMEها میتوانند از مزایای جانبی مانند دسترسی به مدلهای منطقهای (نمونه: Latam-GPT) بهرهبرداری کنند تا محصولات و سرویسهای مختص بازار محلی را سریعتر و با هزینه کمتر توسعه دهند. بهطور خلاصه، هوش مصنوعی ابری بومی به SMEها این امکان را میدهد که بدون سرمایهگذاری عظیم اولیه، خدمات هوشمند و بهینه ارائه کنند.

پیشبینی آینده: تحولات آتی فناوری ابری

نگاهی فنی-اقتصادی به آینده نشان میدهد که هوش مصنوعی ابری بومی روندهای زیر را بههمراه خواهد داشت:

– رشد بازار: پیشبینی میشود بازار هوش مصنوعی ابری بومی تا سال ۲۰۲۷ حدود ۲۰۰٪ رشد را تجربه کند، که نشاندهنده تقاضای فزاینده برای زیرساخت ابری منطقهای و راهکارهای پردازش توزیعشده است.

– توسعه زیرساختهای ابری منطقهای اختصاصی: کشورها و مناطق بهسمت ایجاد مراکز محاسباتی تخصصی برای پشتیبانی از بارهای AI سوق پیدا خواهند کرد تا هم نیازهای قانونی و هم عملکردی را برآورده کنند.

– ادغام پردازش لبهای با معماری ابری: برای کاهش تأخیر و افزایش حریم خصوصی، ترکیب لبه و مرکز دادههای منطقهای بهطور فزایندهای رایج خواهد شد؛ در اینجا ترکیب edge inference با synchronized model updates در مرکز ابری نقش مهمی ایفا میکند.

– ظهور استانداردهای جدید بهینهسازی عملکرد: استانداردهایی برای ارزیابی هزینههای واقعی آموزش مدل، معیارهای اندازهگیری latency تحت بارهای واقعی، و روشهای گزارش دهی مصرف انرژی در آموزش و استنتاج مورد انتظار است.

از منظر فنی، فناوریهایی مانند شبکههای نوری داخلی با توان بالا، پروتکلهای همگامسازی موازی کارآمدتر، و شتابدهندههای تخصصیِ کممصرف، ساختار اکوسیستم را تغییر خواهند داد. همچنین، مدلهای بزرگتر منطقهای مشابه Latam-GPT نشان میدهند که ترکیب دادههای محلی و ظرفیت محاسباتی منطقهای میتواند منجر به مدلهایی شود که از نظر فرهنگی و زبانی دقیقتر عمل کنند؛ این امر پیامدهای مهمی برای توسعه خدمات موضعی و حفاظت از حریم خصوصی دارد (منبع: Wired و اسناد پروژه Latam-GPT).

اقدام عملی: راهکارهای پیادهسازی برای سازمانها

برای پیادهسازی عملی هوش مصنوعی ابری بومی در سطح سازمانی، یک برنامه فنی-مرحلهای توصیه میشود:

1. ارزیابی نیازهای پردازشی فعلی و آینده

– اندازهگیری بار آموزش و استنتاج فعلی، الگوهای ترافیک، و نیاز به پردازش در نزدیکی دادهها.

– برآورد هزینههای شبکه و ذخیرهسازی برای تصمیمگیری در مورد توزیع مدلها.

2. انتخاب پلتفرم ابری مناسب بر اساس موقعیت جغرافیایی

– بررسی ارائهدهندگان محلی و مزایای زیرساخت ابری منطقهای.

– ارزیابی امکانات شتابدهنده (GPU/TPU)، شبکه داخلی با RDMA و SLAهای منطقهای.

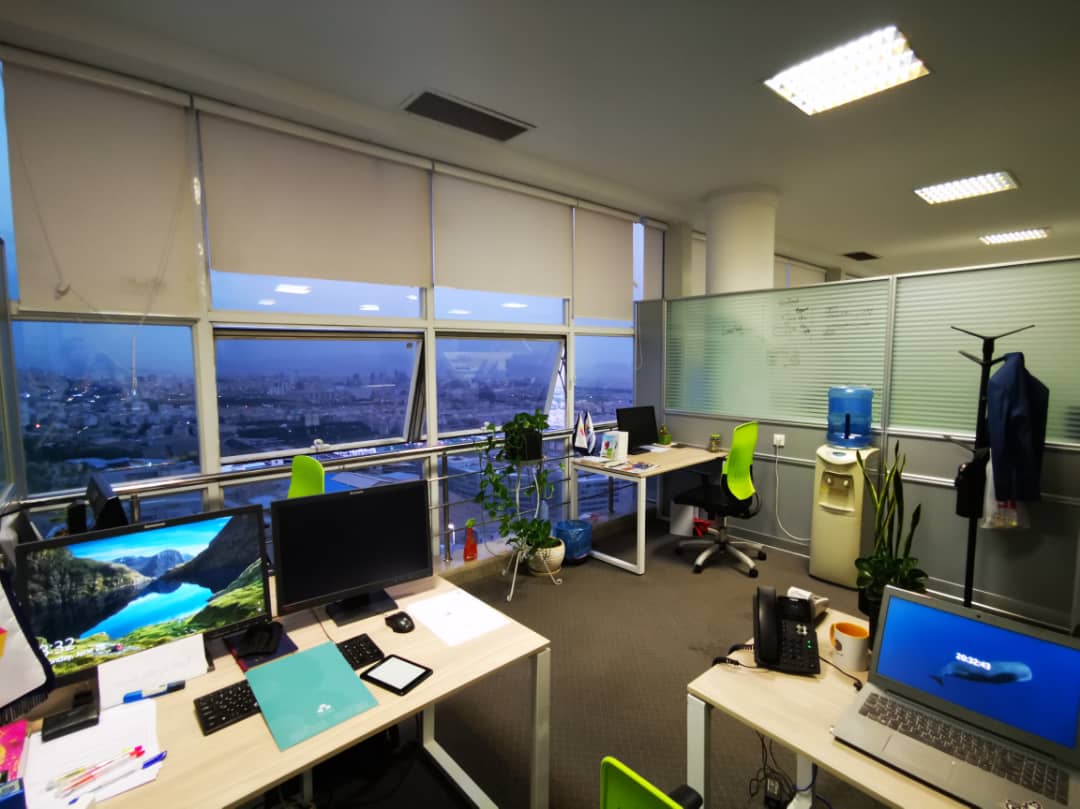

3. آموزش تیمهای فنی بر مفاهیم هوش مصنوعی ابری بومی

– دورههای عملی در موضوعات: Kubernetes برای بارهای شتابیافته، MLOps برای چرخه حیات مدل، و الگوهای مقیاسپذیری.

– کارگاههای عملی برای پیادهسازی pipeline parallelism، mixed precision و quantization.

4. پیادهسازی تدریجی و مانیتورینگ مستمر

– شروع از Proof-of-Concept بر روی بخشی از دادهها و سرویسها؛ استفاده از کانتینرسازی برای جداسازی محیطها.

– استقرار ابزارهای نظارتی برای سنجش latency، throughput، مصرف منابع و کیفیت مدل (drift detection).

– ایجاد سیاستهای بازیابی و تست بار (stress testing) برای سنجش رفتار در پیکهای ترافیک.

توصیه فنی: از استراتژی hybrid-cloud استفاده کنید—استفاده از لبه و زیرساخت ابری منطقهای برای استنتاج حساس و از ابر عمومی یا مرکز محاسباتی برای آموزشهای سنگین بهصورت برنامهریزیشده. این رویکرد ترکیبی بهینهسازی هزینه، تأخیر و انطباق را ممکن میسازد.

نتیجهگیری: فرصتهای طلایی در عصر هوش مصنوعی ابری

هوش مصنوعی ابری بومی بیش از یک فناوری منفرد است؛ این یک استراتژی تحولآفرین است که ترکیب بهینهای از معماری توزیعشده، زیرساخت ابری منطقهای، و تکنیکهای بهینهسازی عملکرد هوش مصنوعی را ارائه میدهد. پروژههایی مانند Latam-GPT نشان میدهند که با سرمایهگذاری در زیرساخت محلی و همکاری منطقهای میتوان مدلهای باکیفیت و فرهنگی-مربوط تولید کرد (برای جزئیات بیشتر به گزارش Wired مراجعه کنید).

آینده متعلق به سازمانهایی است که میتوانند پردازش توزیعشده هوش مصنوعی را بهصورت عملیاتی و مقرونبهصرفه پیادهسازی کنند. برای SMEها، این فرصت به معنای دسترسی به ابزارها و مدلهایی است که پیشتر تنها برای بازیگران بزرگ قابل دسترسی بود. در نهایت، ترکیب زیرساخت ابری منطقهای، مهندسی بارهای AI و گردش کارهای MLOps میتواند مزیت رقابتی پایداری ایجاد کند—مزیتی که هم از منظر فنی و هم از منظر اقتصادی ارزشمند است.

منابع:

– مقاله تحلیلی و گزارش پروژه Latam-GPT در Wired: https://www.wired.com/story/latam-gpt-the-free-open-source-and-collaborative-ai-of-latin-america/

– اسناد و گزارشهای منتشرشده توسط مرکز ملی هوش مصنوعی شیلی (CENIA) و دانشگاه تاراپاکا (مستندات پروژه Latam-GPT)