چرا حاکمیت داده در مراکز تماس هوش مصنوعی حیاتی است؟

مقدمه: انقلاب هوش مصنوعی و چالشهای جدید

رشد سریع سامانههای مبتنی بر هوش مصنوعی در مراکز تماس، نحوهٔ تعامل شرکتها با مشتریان را دگرگون کرده است. در این تحول، حاکمیت داده در مراکز تماس هوش مصنوعی بهعنوان یک ضرورت فنی و حقوقی مطرح میشود؛ چرا که دادهها سوخت اصلی مدلهای هوش مصنوعی هستند و کیفیت، دسترسی و محل ذخیرهسازی آنها تعیینکنندهٔ عملکرد سیستم و سطح ریسک سازمان است. بهطور خاص، مراکز تماس امروز نهفقط مکالمات صوتی و متنی را ثبت میکنند، بلکه از این دادهها برای آموزش مدلها، تحلیل احساسات، و بهبود تجربهٔ مشتری استفاده میکنند؛ بنابراین هر ضعف در سیاستهای حفاظت و مدیریت داده میتواند به نقض حریم خصوصی، جریمههای سنگین یا آسیب به شهرت بینجامد.

در عمل، سازمانهای چندملیتی با مسئلهٔ مدیریت دادههای مرزی (دادههای عبوری از مرزها) مواجهاند که شامل قواعد متفاوت کشوری و الزاماتی مانند محلیسازی داده میشود. این مسائل تکنیکی و حقوقی نیازمند چارچوبهای دقیق مدیریتی، نظارت و مکانیزمهای رضایت کاربران هستند. یک تشبیه ساده کمک میکند: حاکمیت داده در مرکز تماس مانند نگهبانی از یک انبار سوخت حیاتی است؛ اگر مسیرهای ورود و خروج کنترل نشوند، هم خطر نشت هست و هم امکان سوءاستفاده از سوخت برای اهداف غیراخلاقی وجود دارد.

از منظر فنی، معماریهایی مانند جداسازی محیطهای ذخیرهسازی بر اساس حوزهٔ قضایی، رمزگذاری انتها-به-انتها، و استفاده از سیستمهای ثبت و گزارش برای «ردیابی داده» (data lineage) پایههای حاکمیت دادهاند. از منظر حقوقی، پیروی از مقررات محلی و بینالمللی مانند مقررات عمومی حفاظت از دادهها (GDPR) و قانون محافظت از حریم خصوصی مصرفکننده کالیفرنیا (CCPA) الزامی است (برای مرجع: GDPR: https://gdpr.eu/، CCPA: https://oag.ca.gov/privacy/ccpa). افزون بر این، تغییرات اخیر سیاستهای شرکتهای ارائهدهندهٔ خدمات هوش مصنوعی نشان میدهد که حتی خود تأمینکنندگان مدلها نیز در حال تنظیم رفتارهای دادهای خود هستند؛ نمونهٔ اخیر اعلام تغییرات Anthropic در سیاستهای استفاده از گفتگوها برای آموزش مدل که گزینهٔ انتخاب خروج (opt-out) را در پی دارد، نمونهای روشن از این روند است (منبع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/).

در بخشهای بعدی، به پیشینهٔ مقررات، روندهای فعلی، الزامات حوزهای، پیشبینیهای آتی و راهکارهای عملی برای استقرار نظام حاکمیت داده در مراکز تماس هوش مصنوعی میپردازیم.

—

پیشینه: تکامل مقررات حفاظت از داده

تکامل قوانین حفاظت از داده طی دههٔ گذشته نقشی محوری در شکلگیری مفهوم حاکمیت داده داشته است. دو نقطهٔ عطف قابل توجه عبارتاند از تصویب مقررات عمومی حفاظت از دادهها (GDPR) در اتحادیهٔ اروپا و قانون محافظت از حریم خصوصی مصرفکننده کالیفرنیا (CCPA) در ایالات متحده. GDPR الزاماتی مانند حداقلسازی داده، حقوق دسترسی و اصلاح، گزارش نقض داده و ارزیابیهای اثر حریم خصوصی را وضع میکند. در مقابل، CCPA بر حقوق مصرفکننده نسبت به اطلاعرسانی، حذف و جلوگیری از فروش دادهها تمرکز دارد. این دو چارچوب، بهعلاوهٔ مقررات ملی دیگر، پایههایی را فراهم کردهاند که شرکتها باید در طراحی سیستمهای مراکز تماس هوش مصنوعی در نظر بگیرند (مرجع برای GDPR و CCPA: https://gdpr.eu/ و https://oag.ca.gov/privacy/ccpa).

قوانین محلی و حوزهای معمولا دربارهٔ محل ذخیرهسازی و پردازش داده محدودیتهایی قائل میشوند؛ مفهومی که اغلب با اصطلاح «محلیسازی داده» شناخته میشود. کشورهای مختلف، بهخصوص در حوزههای حساس مانند مالی، سلامت و خدمات عمومی، از سازمانها خواستهاند دادههای شهروندان را در داخل مرزهای خود نگه دارند یا پردازشکنندگان خارجی را ملزم به رعایت شرایط ویژه کنند. نمونههایی از جریمههای سنگین برای نقض مقررات وجود دارد که نشان میدهد هزینهٔ غفلت بسیار بالاست؛ جریمههای GDPR در موارد نقض جدی میتواند درصدی از درآمد سالانهٔ شرکت باشد، که بهوضوح اهمیت رعایت را نشان میدهد.

در حوزهٔ مراکز تماس هوش مصنوعی، چالش ترکیب الزامات فنی با الزامات قانونی است: چگونه دادههای صوتی یا متنی که ممکن است شامل اطلاعات حساس باشند، ذخیره، پردازش و برای آموزش مدل استفاده شوند؟ پاسخ سنتی شامل موارد زیر است:

– دستهبندی و فیلتر کردن اطلاعات حساس پیش از ذخیره،

– پیادهسازی سیاستهای حداقلسازی و مدتزمان نگهداری مشخص،

– ثبت ارتباطات و ایجاد مکانیسمهای رضایت آگاهانه.

علاوه بر قوانین رسمی، ظهور سیاستهای حریم خصوصی شرکتهای ارائهدهندهٔ فناوری نیز تأثیرگذار بوده است. برای مثال، Anthropic اخیراً تغییراتی در سیاستهای خود اعلام کرده که امکان استفاده از مکالمات کاربران برای آموزش مدل را در صورت رضایت فراهم میکند و برای کاربران گزینهٔ خروج را تعیین کرده است؛ این موضوع نشان میدهد که حتی تأمینکنندگان مدل نیز در حال تطبیق با فشارهای قانونی و عمومی هستند (منبع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/).

در مجموع، پیشینهٔ مقررات حفاظت از داده نشان میدهد که سازمانهای فعال در حوزهٔ مراکز تماس هوش مصنوعی باید فراتر از الزامات پایه عمل کنند و معماریهای فنی و فرآیندهای سازمانی را طوری طراحی کنند که با تغییرات قانونی و انتظارات کاربران هماهنگ باشد.

—

روند فعلی: افزایش توجه به حاکمیت داده در مراکز تماس AI

در سالهای اخیر، چند روند کلیدی در بازار و فناوری موجب افزایش توجه به حاکمیت داده در مراکز تماس هوش مصنوعی شدهاند. نخست، رشد استفاده از راهحلهای انطباق خودکار (automated compliance) که بهصورت نرمافزاری سیاستها را اجرا، گزارش و روندها را پایش میکنند. این ابزارها از الگوریتمهای پردازش زبان طبیعی برای شناسایی دادههای حساس، برچسبگذاری (tagging) و اعمال قوانین نگهداری بهره میبرند و به تیمهای فنی امکان میدهند تا در مقیاس بزرگ \”مدیریت انطباق\” را خودکار کنند.

دوم، اهمیت مدیریت دادههای مرزی (دادههایی که بین کشورها یا حوزههای قضایی منتقل میشوند) در محیطهای چندملیتی پررنگتر شده است. شرکتهایی که بهصورت بینالمللی عمل میکنند باید معماریهایی برای تقسیمبندی داده بر اساس قوانین محلی داشته باشند؛ بهعنوان مثال، ذخیرهسازی گفتگوهای مشتریان اروپایی در دیتاسنترهای داخل اتحادیهٔ اروپا برای رعایت GDPR، یا تنظیم سیاستهای نگهداری متفاوت برای کاربران در ایالتهای مختلف آمریکا در همخوانی با CCPA.

سوم، تأمینکنندگان بزرگ پلتفرمهای هوش مصنوعی در حال بازنگری سیاستهای دادهای خود هستند تا برای کسبوکارها امکان انطباق با مقررات را فراهم کنند. نمونهٔ اخیر تغییرات در سیاستهای Anthropic که امکان استفاده از مکالمات برای آموزش مدل را تحت شرایط مشخص و با گزینهٔ opt-out فراهم میکند، نشاندهندهٔ فشار برای شفافیت و گزینهدهی به کاربران است؛ براساس گزارش منتشرشده، کاربرانی که رضایت دهند، مکالماتشان تا پنج سال برای آموزش نگهداری میشود، در حالی که کاربران opt-out دادهها را فقط تا سی روز نگه میدارند (منبع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/). این نمونه نشان میدهد که سیاستهای نگهداری و شفافیت دربارهٔ استفاده از دادهها بهطور فزایندهای اهمیت پیدا کردهاند.

چهارم، ترکیب ابزارهای فنی با فرایندهای حقوقی و سازمانی؛ شرکتهای پیشرو اکنون تیمهای ترکیبی از مهندسان، کارشناس حریم خصوصی و حقوقدانان را برای طراحی سیاستهای \”حاکمیت داده\” ایجاد میکنند. این تیمها بر پیادهسازی سیاستهایی مانند محلیسازی داده، رمزگذاری در سطح بالا، و ثبت دقیق دسترسیها (audit trails) تمرکز دارند.

نگاه آینده: پیشبینی میشود استفاده از راهکارهای مبتنی بر هوش مصنوعی برای مدیریت انطباق خودکار، یعنی ابزارهایی که بهصورت پویا قوانین حوزه قضایی را تشخیص داده و سیاستهای ذخیرهسازی و پردازش را اعمال میکنند، افزایش یابد. این حرکت میتواند هزینهٔ رعایت مقررات را کاهش دهد و ریسک نقض را پایین بیاورد، اما همزمان نیازمند شفافیت بیشتر از طرف تأمینکنندگان سرویسهای هوش مصنوعی است.

—

بینش تخصصی: الزامات حوزه قضایی و انطباق

برای پیادهسازی مؤثر حاکمیت داده در مراکز تماس هوش مصنوعی، تحلیل دقیق الزامات هر حوزه قضایی ضروری است. این تحلیل شامل شناسایی قواعد مربوط به محل ذخیرهسازی، مدتزمان نگهداری، انواع دادههای حساس، و حقوق کاربران است. بهعنوان مثال، برخی کشورها پردازش دادههای سلامت یا مالی را تحت قوانین سختگیرانهتری قرار میدهند و نیازمند نگهداری در مراکز داده داخلی یا مجوزهای خاص از نهادهای محلی هستند.

چند گام کلیدی برای فرآیند تحلیل و انطباق:

– تدوین نقشهٔ داده (data mapping): مشخص کنید چه نوع دادهای از کجا میآید، چگونه پردازش میشود و کجا ذخیره میگردد.

– ارزیابی ریسک حریم خصوصی: اجرای ارزیابی اثر حریم خصوصی (PIA) برای شناسایی نقاط ضعف در جریانهای دادهای.

– طبقهبندی دادهها: تفکیک دادهها بر اساس حساسیت و اعمال سیاستهای متفاوت برای هر دسته.

– تعیین سیاستهای نگهداری و حذف: طراحی سیاستهای نگهداری که با الزامات محلی سازگار باشند (مثلاً مدت محدود نگهداری محتوای مکالمات).

برای بومیسازی داده در مراکز تماس، راهکارهای عملی عبارتاند از:

– استفاده از دیتاسنترهای محلی یا منطقهای بهجای انتقال همهٔ دادهها به یک منطقهٔ مرکزی.

– پیادهسازی رمزگذاری جداگانه برای هر حوزهٔ قضایی و مدیریت کلیدها در داخل همان حوزه.

– ترکیب پردازش لبه (edge processing) برای تحلیل فوری و ارسال فقط متادیتا یا نتایج جمعبندیشده به سرویسهای مرکزی.

اهمیت مکانیزمهای رضایت و حق انتخاب کاربران نباید دستکم گرفته شود. فراهم کردن فرمهای رضایت شفاف، گزینههای خروج (opt-out)، و ابزارهایی برای درخواست حذف یا دسترسی به دادهها، بخشی از تعهدات قانونی و اخلاقی است. مثال عملی: در سیاستهای جدید برخی شرکتها (همانند Anthropic) گزینهٔ صریحی برای عدم استفاده از مکالمات در آموزش مدل قرار دادهاند و دورهٔ نگهداری داده برای کاربران موافق و مخالف متفاوت اعلام شده است؛ این رویکرد نمونهای از ترکیب سیاست فنی و شفافیت حقوقی است (مرجع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/).

از منظر فنی، پیادهسازی «ردیابی چرخهٔ داده» (data lineage)، لاگهای تفصیلی، و داشبوردهای گزارشدهی برای نشان دادن انطباق در زمان واقعی ضروری است. همچنین «مدیریت انطباق» باید شامل فرآیندهای بازبینی منظم، ممیزیهای خودکار و سیاستهای پاسخ به نقض داده باشد. در نهایت، هماهنگی بین تیمهای فنی، حقوقی و کسبوکار برای اجرای موفق این الزامات غیرقابل اجتناب است.

—

پیشبینی آینده: تحولات آتی در حاکمیت داده

آیندهٔ حاکمیت داده در مراکز تماس هوش مصنوعی احتمالاً با چند تغییر ساختاری و تکنولوژیک همراه خواهد بود. نخست، انتظار میرود مقررات در سطح جهانی سختگیرانهتر شود و چارچوبهای هماهنگتری پدید آید که انتقالهای مرزی داده و استفاده از دادهها برای آموزش مدلهای هوش مصنوعی را دقیقتر تنظیم کند. این روند میتواند شامل استانداردهای بینالمللی برای شفافیت دربارهٔ استفاده از دادهها و الزامات گزارشدهی دربارهٔ مدلها باشد.

دوم، ظهور فناوریهای جدید برای مدیریت انطباق خودکار شتاب خواهد گرفت. این ابزارها از هوش مصنوعی برای شناسایی خودکار دادههای حساس، تحلیل خطرات انطباق و پیشنهاد سیاستهای مناسب بر اساس محل کاربر استفاده میکنند. به بیان دیگر، همانطور که مدلهای هوش مصنوعی میتوانند مکالمات را تحلیل کنند، مدلهای دیگری نیز برای نظارت بر رعایت قوانین و اعمال سیاستها در سطح زیرساختی توسعه مییابند.

سوم، تأثیر هوش مصنوعی بر شفافیت و پاسخگویی محسوس خواهد شد. مقررات ممکن است الزاماتی برای «قابلیت توضیحپذیری» مدلها وضع کنند؛ یعنی سازمانها باید بتوانند توضیح دهند که چگونه مدل به نتایج رسیده و چه دادههایی در آموزش آن بهکار رفته است. این موضوع به ویژه در مراکز تماس اهمیت دارد، زیرا تصمیمات خودکار میتواند بر تجربهٔ مشتری یا نتایج حقوقی تأثیر بگذارد.

چهارم، مدلهای تجاری در حوزهٔ ارائهدهندگان سرویس نیز تغییر میکند: شرکتها تمایل خواهند داشت به سرویسهای «خصوصی» یا «مجوزی» که کنترل بیشتری روی دادهها و محلیسازی فراهم میکنند، مهاجرت کنند. همچنین، امکان ظهور بازارهای جدیدی برای سرویسهای مدیریت انطباق و حفاظت داده به وجود خواهد آمد.

پیشبینی کوتاهمدت (۳–۵ سال): افزایش استفاده از ابزارهای خودکار مدیریت انطباق و گزارشدهی، الزام به شفافیت بیشتر از طرف ارائهدهندگان مدل و رشد تقاضا برای دیتاسنترهای منطقهای.

پیشبینی بلندمدت (۵–۱۰ سال): ایجاد استانداردهای بینالمللی برای بهرهبرداری از دادههای مشتریان در آموزش مدلهای هوش مصنوعی و توسعهٔ تکنیکهای حریم خصوصی مثل یادگیری فدرال و رمزنگاری کاربردی که امکان آموزش مدل بدون انتقال دادهٔ خام را فراهم کنند.

این تحولات نشان میدهد که سرمایهگذاری در حاکمیت داده نهفقط یک الزام حقوقی، بلکه مزیت رقابتی در آینده خواهد بود.

—

اقدام عملی: راهکارهای پیادهسازی حاکمیت داده

برای تبدیل مفهوم حاکمیت داده به عمل در مراکز تماس هوش مصنوعی، مجموعهای از گامهای فنی و سازمانی باید همزمان اجرا شود. در ادامه یک مسیر پیشنهادی تفصیلی آمده است:

گامهای عملی

– ارزیابی اولیه (Discover & Map): انجام نقشهٔ دادهٔ کامل برای شناسایی جریانهای ورودی، ذخیرهسازی و خروجیها.

– طبقهبندی و برچسبگذاری خودکار: پیادهسازی ابزارهای پردازش زبان برای شناسایی و علامتگذاری دادههای حساس.

– طراحی معماری منطقهای: تفکیک ذخیرهسازی و پردازش بر اساس حوزهٔ قضایی (محلیسازی داده) و استفاده از دیتاسنترهای منطقهای یا ابرهای مجاز.

– رمزگذاری و مدیریت کلید: اعمال رمزگذاری قوی و نگهداری کلیدها داخل حوزهٔ قضایی مربوطه.

– سیاستهای نگهداری و حذف خودکار: تعیین دورههای نگهداری متفاوت بر اساس نوع داده و قوانین محلی، و خودکارسازی حذف پس از اتمام دوره.

– مکانیسمهای رضایت: طراحی رابطهای شفاف برای جمعآوری رضایت کاربران و فراهم کردن گزینههای opt-out.

– مانیتورینگ و گزارشدهی: پیادهسازی داشبوردهای انطباق، لاگهای قابل حسابرسی و اعلانهای فوری در صورت نقض.

– آموزش و فرهنگسازی: برگزاری دورههای آموزشی برای پرسنل مرکز تماس دربارهٔ اهمیت حاکمیت داده و رویههای عملی.

ابزارها و پلتفرمهای پیشنهادی

– سامانههای مدیریت سیاست (Policy Engines) برای اجرای خودکار قوانین.

– ابزارهای DLP (پیشگیری از نشت داده) و فیلترینگ محتوای حساس.

– راهکارهای مدیریت هویت و دسترسی (IAM) و ثبت دقیق فعالیتها (audit trails).

– تکنولوژیهای حریم خصوصی مانند یادگیری فدرال، رمزنگاری همیاری یا تکنیکهای anonymization برای کاهش نیاز به اشتراک دادهٔ خام.

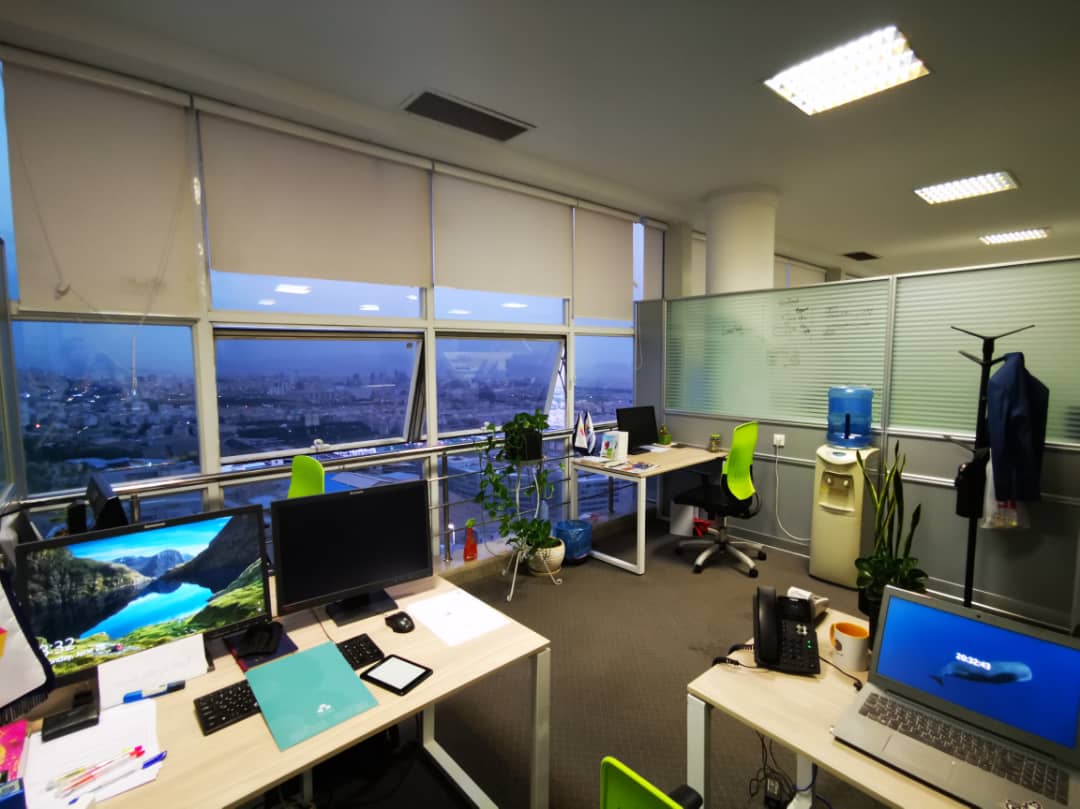

تماس برای مشاوره رایگان و ارزیابی وضعیت فعلی

اگر سازمان شما در مسیر پیادهسازی یا بازبینی حاکمیت داده در مراکز تماس هوش مصنوعی است، یک ارزیابی اولیه میتواند نقاط ضعف را آشکار و مسیر عملیاتی را مشخص کند. ما میتوانیم:

– نقشهٔ داده و ارزیابی ریسک را اجرا کنیم،

– پیشنهادات معماری براساس الزامات حوزهٔ قضایی ارائه دهیم،

– و پیادهسازی نمونهٔ اولیهٔ ابزارهای مدیریت انطباق را همراه شما آغاز کنیم.

برای کسب اطلاعات بیشتر و درخواست مشاوره رایگان، میتوانید فرم تماس را پر کنید یا با تیم فنی ما ارتباط برقرار نمایید. حاکمیت داده نهفقط برای رعایت مقررات ضروری است، بلکه کلید حفظ اعتماد مشتری و تداوم کسبوکار در عصر هوش مصنوعی است.

منابع و مطالعات تکمیلی:

– گزارش تغییرات سیاستهای Anthropic دربارهٔ استفاده از مکالمات برای آموزش مدل (Zoomit): https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/

– مرجع جامع GDPR: https://gdpr.eu/

– اطلاعات مرتبط با CCPA: https://oag.ca.gov/privacy/ccpa/