شفافیت در آموزش هوش مصنوعی: کلید اصلی اعتماد مشتریان

مقدمه: چرا شفافیت در آموزش هوش مصنوعی حیاتی است؟

در عصر حاضر که هوش مصنوعی بهسرعت در خدمات مشتری، پشتیبانی و محصولسازی نفوذ میکند، اعتماد مشتری بهعنوان یکی از سرمایههای مهم هر کسبوکاری مطرح شده است. شفافیت در آموزش هوش مصنوعی و نحوه استفاده از دادههای کاربران میتواند تفاوت بین پذیرش گسترده یا پسزدن فناوری را رقم بزند. وقتی کاربران نمیدانند دادههایشان چگونه جمعآوری، نگهداری و در مدلها استفاده میشود، احساس عدماطمینان و ریسک حریم خصوصی افزایش مییابد؛ بنابراین ایجاد سازوکارهای روشن و قابل فهم برای آموزش مشتری (customer education) و برقراری ارتباط مؤثر (communication strategies) ضروری است.

در ماهها و سالهای اخیر، تغییرات سیاستهای شرکتهای فعال در حوزه هوش مصنوعی، از جمله اعلامیهها و بهروزرسانیهای حریم خصوصی، نشاندهندهی نیاز به تعادل میان بهبود مدلها و حفاظت از کاربران است. بهعنوان مثال، اعلام تغییر سیاستهای Anthropic برای استفاده از گفتگوهای کاربران در آموزش مدل Claude و ارائه گزینههای opt-out، یک نمونه عملی از این تغییرات است که نشان میدهد شرکتها ناگزیر به شفافتر کردن فرآیندهای خود هستند (جزئیات بیشتر در منبع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/).

اگر بخواهیم یک تشبیه ساده بیاوریم: همانطور که مشتریان در رستوران حق دارند بدانند غذا چگونه و با چه موادی تهیه شده تا تصمیم آگاهانه بگیرند، کاربران دیجیتال نیز حق دارند بدانند دادههایشان چگونه استفاده میشود تا بتوانند تصمیمگیری درستی دربارهی ادامه یا توقف استفاده از سرویس بکنند. بنابراین، ترکیب آموزش مشتری، سیاستهای اخلاقی (ethical AI practices) و استراتژیهای ارتباطی درست، بنیان ایجاد اعتماد را فراهم میآورد.

در این مقاله، قدم به قدم به بررسی پیشینه، روندهای جاری، استراتژیهای ارتباطی، چشمانداز آینده و راهکارهای عملی برای رسیدن به شفافیت در آموزش هوش مصنوعی و تقویت اعتماد مشتریان خواهیم پرداخت.

پیشینه: تحول در سیاستهای استفاده از دادههای کاربران

استفاده از دادههای کاربران برای آموزش مدلهای هوش مصنوعی سابقهای طولانی دارد؛ اما میزان شفافیت و حقوق کاربران در این فرآیند همواره تغییر کرده است. در دههی گذشته، برخی شرکتها بهصورت ضمنی یا در شرایط استفاده (Terms of Service) کلی، حق استفاده از دادهها را برای بهبود محصولات خود محفوظ میداشتند. این رویکرد باعث نگرانی فعالان حریم خصوصی و تنظیمکنندهها شد و فشار برای تعریف مرزهای شفافتر افزایش یافت.

شرکتهای مختلف رویکردهای متفاوتی اتخاذ کردهاند: برخی از آنها بهطور پیشفرض از دادههای کاربران برای آموزش مدلها استفاده میکنند، برخی گزینهی صریح opt-out را فراهم آوردهاند و برخی دیگر برای مشتریان سازمانی یا آموزشی سیاستهای جداگانهای در نظر گرفتهاند. مورد Anthropic نمونهای شاخص است: این شرکت اعلام کرده است که گفتگوهای کاربران میتوانند برای آموزش Claude استفاده شوند، اما گزینههایی برای عدممشارکت (opt-out) در هنگام ثبتنام و از طریق اعلانهای پاپآپ برای کاربران موجود ارائه میشود. همچنین تفاوتهای قابل توجهی در دورههای نگهداری داده وجود دارد؛ برای مثال، کاربرانی که با سیاست جدید موافقت کنند، گفتگوهایشان تا پنج سال نگهداری میشود، در حالی که برای کسانی که امتناع کنند، دورهی نگهداری فقط ۳۰ روز است (منبع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/).

این تحولات نشان میدهد که:

– فشارهای قانونی و عمومی بهسمت شفافیت بیشتر حرکت میکند.

– ارائه گزینههای انتخابی به کاربران تبدیل به یک استاندارد عملی و اخلاقی شده است.

– تقسیمبندی محصولات (مثلاً خدمات تجاری جدا از خدمات عمومی) به شرکتها امکان میدهد تا تعهدات متفاوتی برای حریم خصوصی تعیین کنند، مثلاً Claude for Work یا Claude for Education از قواعد دیگری برخوردار باشند.

از منظر تاریخی، این تغییرات را میتوان بهمثابه گذار از «محرمانگی ضمنی» به «محرمانگی شفاف و انتخابمحور» تفسیر کرد؛ گذاری که در آن «آموزش مشتری» و «روشهای اخلاقی هوش مصنوعی» (ethical AI practices) نقش محوری ایفا میکنند.

روند فعلی: حرکت به سمت شفافیت و انتخاب کاربر

در سالهای اخیر روند مشخصی در صنعت هوش مصنوعی دیده میشود: حرکت به سمت شفافیت بیشتر در فرآیندهای آموزش مدل و ارائه مکانیزمهای انتخاب (opt-in/opt-out) برای کاربران. پیادهسازی این مکانیزمها نه تنها از نظر حقوقی و اخلاقی مهم است، بلکه به عنوان یک استراتژی کسبوکار برای تقویت ساخت اعتماد نیز عمل میکند.

نمونه مشخص این روند را میتوان در تغییر سیاستهای Anthropic مشاهده کرد؛ آنها گزینهی عدمشرکت در استفاده از دادهها برای آموزش را در زمان ثبتنام ارائه میکنند و برای کاربران فعلی، اعلانهایی ارسال میشود تا انتخابشان را ثبت کنند. مهلت تعیینشده برای این opt-out تا ۲۸ سپتامبر ۲۰۲۵ است که نشاندهندهی نیاز به اطلاعرسانی گسترده و برنامهریزی دقیق برای جلب رضایت آگاهانه کاربران است (منبع: https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/).

یکی از نکات کلیدی در این روند، تفاوت دورههای نگهداری داده است:

– برای کاربران موافق: نگهداری دادهها تا ۵ سال برای اهداف آموزش مدل.

– برای کاربران غیرموافق: نگهداری محدود به ۳۰ روز.

این تضاد نشان میدهد که شرکتها تلاش میکنند بین نیاز به داده برای بهبود مدلها و تعهدات حریم خصوصی تعادل برقرار کنند. در این میان، چندین فناوری و فرآیند کمکی نیز مطرح شدهاند:

– استفاده از ابزارهای خودکار برای فیلتر کردن و حذف دادههای حساس قبل از آموزش.

– رمزگذاری و تکنیکهای حفظ حریم خصوصی مانند یادگیری تفاضلی برای کاهش افشای اطلاعات شخصی.

– اعلانهای شفاف و زمانبندیشده برای گرفتن رضایت آگاهانه (informed consent).

مثالی برای وضوح: فرض کنید یک سرویس تلفنی ابری مکالمات کاربران را برای بهبود پاسخدهی هوش مصنوعی ذخیره میکند؛ اگر به کاربران اعلام شود که میتوانند انتخاب کنند مکالماتشان پس از ۳۰ روز پاک شود یا برای بهینهسازی مدل تا ۵ سال نگهداری گردد، تصمیمگیری هم شفافتر و اعتمادسازی آسانتر میشود.

در مجموع، روند فعلی نشان میدهد که ترکیب استراتژیهای شفافیت، نگهداری داده متعادل و ابزارهای فنی حفاظتی، پایهای برای ایجاد اعتماد مشتری و پذیرش گستردهتر فناوری خواهد بود.

بینش عمیق: استراتژیهای ارتباطی برای ساخت اعتماد

ساخت اعتماد با مشتریان در حوزهی هوش مصنوعی نیازمند استراتژیهای ارتباطی دقیق و آموزشی است. «آموزش مشتری» یا customer education باید بهگونهای طراحی شود که کاربران بفهمند چگونه دادههایشان استفاده میشود، چه انتخابهایی دارند و پیامد هر انتخاب چیست. این فرآیند ترکیبی از محتوا، کانالهای ارتباطی و ابزارهای فنی است.

عناصر کلیدی استراتژیهای ارتباطی:

– شفافیت در زبان: استفاده از توضیحات ساده، مثالمحور و قابل فهم بهجای اصطلاحات حقوقی پیچیده.

– زمانبندی پیام: اعلانهای مهم باید قبل از اعمال تغییرات و در بازههای قابل توجه (مثلاً نزدیک به مهلت opt-out) ارسال شوند.

– چندکاناله بودن: اطلاعرسانی از طریق ایمیل، پاپآپ در تعاملات سرویس، صفحات پشتیبانی و FAQ.

– فراهم آوردن ابزارهای تصمیمگیری: نمایش واضح مزایا و معایب هر انتخاب (مثلاً نگهداری ۵ ساله برای بهبود پاسخدهی در مقابل ۳۰ روز نگهداری برای حفظ حریم خصوصی).

ابزارهای فنی که باید در چارچوب ارتباطی معرفی و به کاربران توضیح داده شوند:

– فیلترهای خودکار برای حذف دادههای حساس پیش از آموزش.

– روشهای شبهناشناسسازی و تکنیکهای حفاظتی مانند یادگیری تفاضلی که خطر افشای اطلاعات شخصی را کاهش میدهند.

– تنظیمات قابل دسترس و ساده برای کنترل نگهداری داده و رضایت آگاهانه.

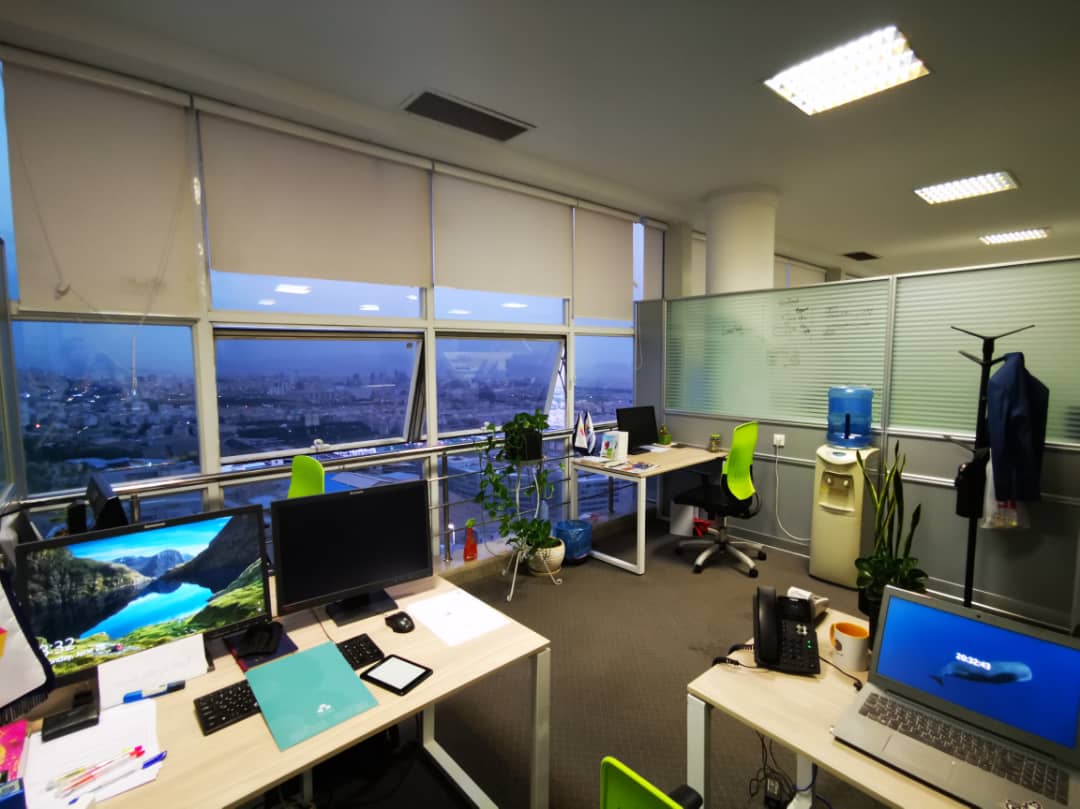

مثال کاربردی: شرکت ارائهدهندهی سرویس تلفن ابری میتواند یک «داشبورد شفافیت» طراحی کند که در آن کاربران ببینند چه نوع دادهای جمعآوری میشود، چگونه فیلتر میشود، و دورههای نگهداری مختلف چه پیامدهایی برای کیفیت سرویس دارد. این داشبورد شبیه برگهی اطلاعات مواد تشکیلدهندهی یک محصول غذایی است که به مصرفکننده امکان میدهد انتخاب آگاهانهای داشته باشد.

در بحث استراتژیهای ارتباطی، رعایت اصول اخلاقی (ethical AI practices) اهمیت دارد. این اصول شامل صداقت، مسئولیتپذیری و پاسخگویی است. سازمانها باید نهتنها اطلاعات را منتشر کنند، بلکه نشان دهند که چگونه از ابزارها و فرایندها برای محافظت از کاربران استفاده میکنند. آینده نشان میدهد که شرکتهایی که استراتژیهای ارتباطی مؤثر و آموزش مشتری قوی داشته باشند، در مقابله با قوانین جدید حفاظت از داده و انتظارات عمومی موفقتر خواهند بود.

آیندهنگری: تحول در شیوههای اخلاقی هوش مصنوعی

آیندهی آموزش هوش مصنوعی و شفافیت در استفاده از دادهها بهسمت استانداردهای بالاتر اخلاقی و رعایت حریم خصوصی پیش خواهد رفت. با شدت گرفتن نظارت قانونی و افزایش حساسیت عمومی نسبت به موضوعات حریم خصوصی، شرکتها مجبور به بازنگری سیاستها و ایجاد سازوکارهای شفافتر خواهند شد.

پیشبینیها و روندهای احتمالی:

– قوانین سختتر حفاظت از داده: همانطور که در سالهای اخیر دولتها چارچوبهای جدیدی را پیشنهاد یا اجرا کردهاند، انتظار میرود مقررات مرتبط با استفاده از دادههای کاربران برای آموزش مدلهای AI تشدید شود. این تحولات فشار برای پذیرش روشهای privacy-first را افزایش میدهد.

– استانداردهای صنعت: سرویسهای سازمانی و شرکتی (مانند نسخههای تجاری چتباتها یا سرویسهای ابری) ممکن است بهعنوان آزمایشگاههای استانداردسازی عمل کنند؛ مثالهایی مانند Claude for Work یا Claude for Education میتوانند الگوهای برتر اخلاقی را نمایش دهند.

– فناوریهای محافظتی جدید: توسعه روشهایی مانند یادگیری تفاضلی، رمزنگاری همکارانه و فیلترینگ خودکار دادههای حساس بهبود مییابد و به شرکتها امکان میدهد بدون قربانی کردن کلی عملکرد، حریم خصوصی را تقویت کنند.

– فرهنگ سازمانی مبتنی بر شفافیت: شرکتها بهتدریج شفافیت را جزئی از برند خود خواهند کرد؛ یعنی شفافیت در آموزش هوش مصنوعی تبدیل به یک ارز اعتماد میشود.

از منظر کسبوکار، شرکتهایی که از هماکنون استراتژیهای «آموزش مشتری» و «روشهای اخلاقی هوش مصنوعی» را پیادهسازی کنند، در آینده مزیت رقابتی خواهند داشت. آنها نهتنها کمتر در معرض ریسکهای حقوقی و رسانهای خواهند بود، بلکه مشتریانی وفادارتر و مشارکت بیشتر در بهبود محصولات خواهند داشت.

یک مثال پیشبینیشده: در پنج سال آینده، بسیاری از سرویسها بهصورت پیشفرض گزینهای برای «حالت حریم خصوصی» ارائه خواهند کرد که در آن دادهها تنها برای خدمات فوری و نه برای آموزش مدل بلندمدت نگهداری میشوند؛ این حالت میتواند برای کاربران حساس یا سازمانهای دارای مقررات سخت مفید باشد.

در نهایت، نقش سرویسهای سازمانی در تعیین استانداردها حیاتی خواهد بود؛ زیرا آنها معمولاً نیازمندیهای بالاتری در زمینه حفاظت از داده و شفافیت دارند و میتوانند استانداردهای خوب را به بازار عمومی منتقل کنند.

اقدام عملی: چگونه اعتماد مشتریان را جلب کنیم؟

برای عملی کردن شفافیت در آموزش هوش مصنوعی و تقویت اعتماد مشتریان، پیشنهادات زیر بهصورت کاربردی و قابل اجرا آورده شده است. این راهکارها ترکیبی از سیاست، فناوری و ارتباطات هستند.

اقدامات پیشنهادی:

– تدوین سیاستهای نگهداری داده متعادل:

– پیشنهاد: دورههای نگهداری متفاوت بر اساس سطح رضایت کاربر (مثلاً ۳۰ روز برای عدمموافقت، ۵ سال برای موافقتشده) با قابلیت شفاف نمایش.

– مزیت: تعادل بین نیاز به داده برای بهبود مدل و حفاظت از حریم خصوصی.

– مکانیزمهای رضایت آگاهانه:

– پیادهسازی فرایند opt-in/opt-out ساده و قابل فهم در هنگام ثبتنام و در داشبورد حساب کاربری.

– ارسال اعلانها و یادآوریهای زمانبندیشده پیش از مهلتها (مثلاً مهلت ۲۸ سپتامبر ۲۰۲۵ در نمونه Anthropic).

– ابزارهای خودکار برای فیلتر کردن دادههای حساس:

– استفاده از ترکیب فیلترهای مبتنی بر قوانین و مدلهای تشخیص خودکار برای حذف یا ماسکگذاری اطلاعات حساس پیش از ذخیره برای آموزش.

– رعایت استانداردهای حقوقی در حوزههای مختلف جغرافیایی.

– آموزش مشتری و شفافسازی:

– تولید محتوای آموزشی ساده (ویدئو، مقاله، سوالات متداول) که توضیح میدهد دادهها چگونه به بهبود خدمات کمک میکنند و چه گزینههایی وجود دارد.

– برگزاری وبینارها یا جلسات پرسش و پاسخ برای مشتریان سازمانی.

– گزارشدهی و حسابرسی:

– انتشار گزارشهای دورهای درباره نحوه استفاده از دادهها، نتایج فیلترینگ دادههای حساس و اثرات بهبود مدل.

– فراهم آوردن امکان حسابرسی برای مشتریان سازمانی.

– طراحی داشبورد شفافیت:

– داشبوردی که کاربران بتوانند نوع دادههای جمعآوریشده، مدت نگهداری و وضعیت فیلترینگ را ببینند و تنظیمات خود را تغییر دهند.

چکلیست سریع برای اجرا:

– [ ] بازبینی و سادهسازی سیاستهای حریم خصوصی

– [ ] پیادهسازی مکانیزم opt-out/opt-in واضح

– [ ] استقرار فیلترهای خودکار برای دادههای حساس

– [ ] آمادهسازی محتوای آموزشی برای مشتریان

– [ ] ایجاد داشبورد شفافیت و گزارشدهی منظم

منابع و مثالها: برای درک بهتر نحوهی اجرای این سیاستها میتوان به اطلاعیهی شرکت Anthropic و نحوهی مدیریت آن اشاره کرد. جزئیات تغییرات سیاستها و دورههای نگهداری داده در این منبع توضیح داده شده است (https://www.zoomit.ir/ai-articles/446991-anthropic-claude-chat-training/). همچنین، مشاهده کنید که چگونه ترکیب ابزارهای فنی و ارتباطی میتواند به رضایت آگاهانه کاربران منجر شود.

نتیجهگیری کوتاه: شفافیت در آموزش هوش مصنوعی و اجرای روشهای اخلاقی موجب تقویت اعتماد مشتریان، کاهش ریسکهای حقوقی و افزایش کیفیت محصولات میشود. با اتخاذ رویکردهای عملی فوق و سرمایهگذاری در آموزش مشتری و استراتژیهای ارتباطی، کسبوکارها میتوانند بهصورت مسئولانه و پایدار از دادهها برای بهبود مدلهای AI بهرهمند شوند.